我们经常听到客户问如下问题:原生开源大模型就能OCR识别,为什么要采购易道博识二次训练的OCR大模型,价值在哪?

事实上,在未经调优的情况下,直接将原生大模型用于OCR识别,很难满足生产要求。

大模型OCR的技术路径与固有局限

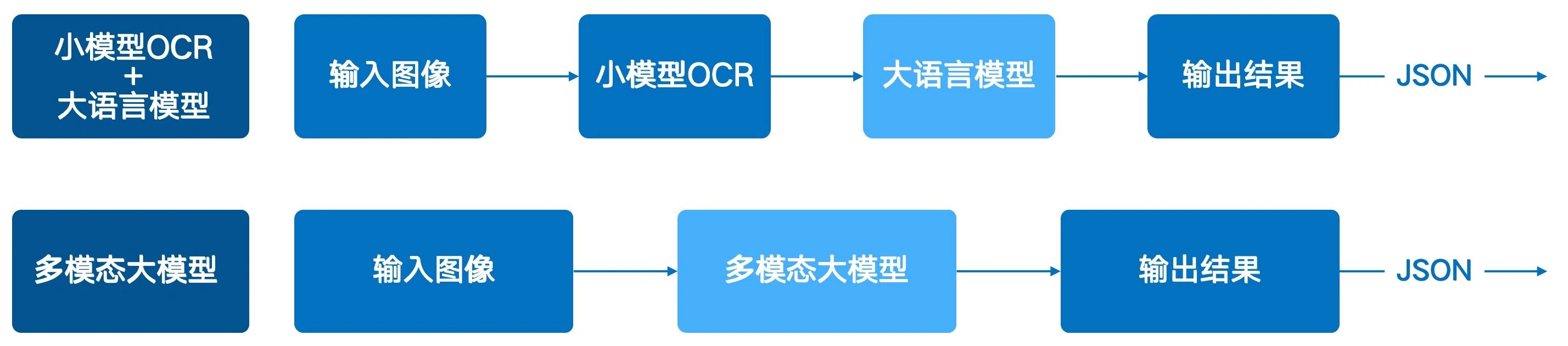

大模型实现OCR功能主要通过两种技术路径,两者在架构上决定了其在实际应用中的固有局限。

多模态大模型:多模态大模型是“图像输入→文本输出” 的端到端解决方案。模型通过统一的架构直接理解图像中的视觉特征(如文字、布局)和语义信息,一步完成识别与信息提取。

当原生大模型在应用于专业的OCR任务时,暴露出以下局限:

1、识别准确率不足

● 字符识别:在手写体、印刷质量不佳或存在生僻字的情况下,识别错误率较高。

● 表格识别:对于包含合并单元格或复杂排版的表格,结构识别和内容提取的准确率会大幅下降。

● 数据提取:当文档中缺少明确的关键字作为定位锚点时,模型提取特定字段的准确性显著降低。

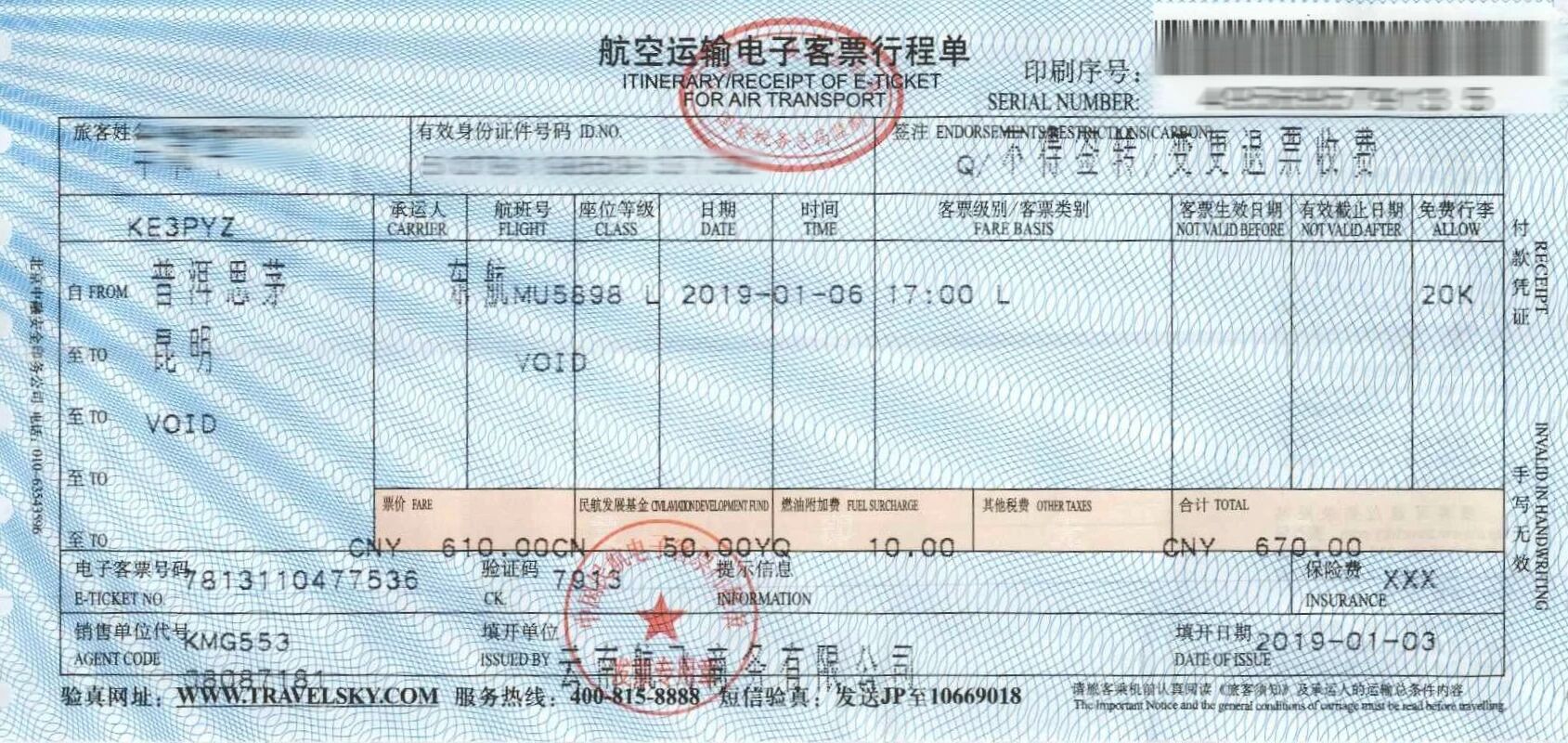

● 版式兼容性:在企业的财务流程中,发票、银行回单、结算凭证等套打文档无处不在,然而,一旦打印过程出现物理偏移,例如,发票上的关键字段“金额”或“收款人”未能精确打印在预设的表格框线内,模型便难以识别。

2、存在幻觉

“幻觉”是指模型生成了与图像实际内容不符但看似合理的结果。

● 语义覆盖内容:当图像文字模糊时,模型可能依据上下文“脑补”出错误但符合逻辑的内容。例如,将模糊的金额“198”识别为更常见的“199”。

● 无中生有:对于图像中本应为空白的字段,模型可能会强制生成内容。

● 长文本连贯性幻觉:对于长段落文本(如书籍扫描页),大模型为保证输出文本的连贯性,可能对个别识别模糊的词进行 “合理化修正”,导致局部文本与原图不符。

3、识别结果无法溯源

原生大模型在识别文本后,通常不提供其在原始图像中的具体坐标位置,导致识别结果无法溯源。

这一局限在实际应用中会带来两类关键问题:

操作层面,当识别结果出错时,用户无法快速定位原文进行人工校对;

合规层面,尤其在金融、医疗等监管严格的领域,审计要求OCR结果必须与原始凭证的原文精确对应,因此,缺乏坐标溯源能力的技术无法满足其合规标准。

4、精度与成本难平衡

模型精度与其参数规模正相关。千亿级参数的大模型能达到更高的识别精度,但其推理计算必须依赖A100/H100级别的高端GPU,这使得硬件部署成本十分高昂。

反之,如果为了控制成本而采用参数裁剪或量化压缩后的轻量化模型,会导致跨模态注意力机制、视觉特征编码能力受损,OCR 精度大幅下降。例如,某多模态模型的 7B 参数版本在表格识别任务中的准确率比 130B 版本低 20% 以上。

为克服原生大模型的局限,易道博识采用“选择模型与评测短板 - 定向训练 - 验证效果”的闭环流程,对基础大模型进行二次训练与调优。

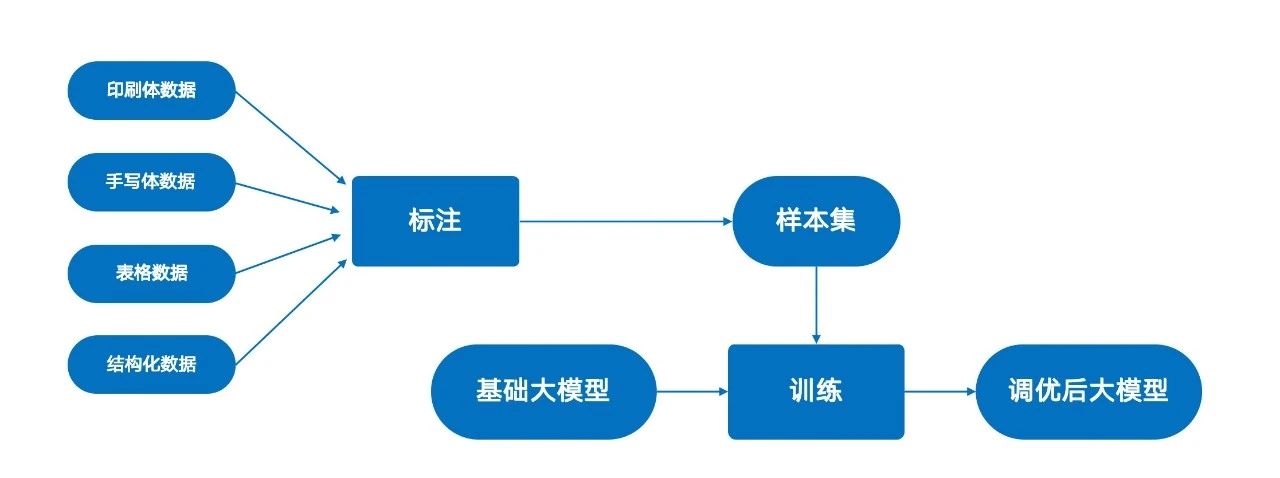

1. 选择与评测基础模型: 首先,根据任务需求(如场景、语言、精度要求)选择一个基础大模型。在调优前,对其OCR能力进行全面评测,包括在印刷体、手写体、不同噪声背景下的文本识别准确率,以及表格识别和上下文理解能力,从而定位其具体短板,为后续训练数据的筛选和调优策略(如重点强化手写体数据的训练)提供指导。

2. 定向数据训练: 基于评测结果,构建针对性的训练数据集。简单来说,大模型在哪方面能力偏差,就要相应的增加相关训练数据。

例如,若模型对手写体识别能力较弱,则在训练数据中增加手写样本的比例。我们使用海量经过专业标注的OCR数据,覆盖印刷体、手写体、各类表格及结构化文档,对基础大模型进行二次训练,以增强其在特定任务上的特征学习能力。

3. 评估与验证: 训练完成后,在独立的测试集上对调优后模型的各项性能指标进行重新评估,以验证其相较于原生模型的提升,最终实现高精度、高鲁棒性的 OCR 应用。

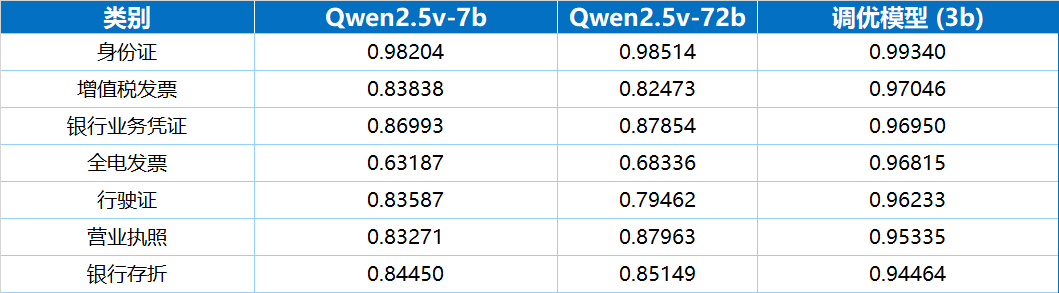

通过二次训练,模型在准确率、速度和功能完备性上均获得了显著提升。最为重要的是,基于相对轻量化的大模型,经过二次训练,其OCR综合能力要远好于更大参数规模的原生大模型,

丨准确率:30亿参数模型优于720亿参数模型

评测结果显示,一个30亿参数的多模态大模型经过二次训练后,其在多种真实业务票据上的端到端识别准确率,不仅高于70亿参数的原生模型,甚至全面优于720亿参数的原生模型。

在相同的A100(80G)硬件环境下,处理同等复杂度的增值税发票,720亿参数的Qwen模型平均耗时21.43秒,而调优后的30亿参数模型仅需3.23秒,处理速度为前者的6.63倍。

此外,通过并行任务设计和工程上的优化,进一步加速了大模型推理:在信息抽取任务上,将实体抽取、表格抽取任务拆开并行计算,理论速度可再提升最高100%。

与原生大模型不同,经过二次训练的模型支持输出每个识别字段在原始图像中的精确坐标。这一功能解决了结果无法溯源的问题,满足了业务核验与合规审计的需求。

为降低大模型在业务系统中的使用门槛,我们进行了两项关键的工程化改造。

大模型与普通 OCR 接口在输入输出逻辑上存在显著差异:

传统 OCR 接口采用 "图像→结构化数据" 的固定模式,通常仅接收图像输入,输出包含文字内容及位置信息的 JSON 格式数据。

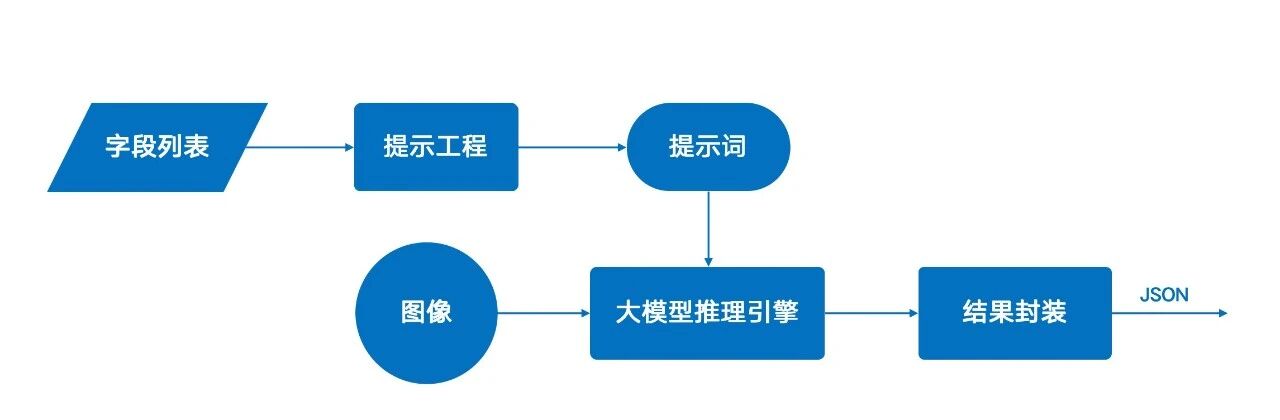

原生大模型采用“图像+提示词”的协同输入模式,其优势在于能进行深度语义理解,实现更精准的信息提取。

然而,这一模式也带来了两个问题:一是要求用户具备为不同文档设计提示词的能力,二是其流式输出与标准的JSON格式不兼容,这都显著增加了非专业用户的使用门槛。

为此,易道博识通过工程化手段,将复杂的调用逻辑封装成标准API。用户只需提供图像和待提取的字段列表,系统即可自动构建提示词并返回结构化的JSON结果,其使用体验与传统OCR接口一致。

由于用户无需自行定义复杂的提示词,也无需处理复杂的和大模型的交互过程,因而接口更加方便易用。

从当前技术实践来看,大模型更多是对小模型的有益补充,而非全然替代。二者的深度融合,才是现阶段应对复杂场景的最优解。

需要注意的是,原生状态下的大模型与小模型往往难以实现深度协同 。传统解决方案多采用独立部署模式,在应用层根据具体需求分别调用大模型或小模型的接口,这种方式难以突破 “各自为战” 的局限。

而易道博识通过系统化的工程化手段,成功实现了大小模型的深度融合,智能文档处理平台(简称DeepIDP)架构如下:

DeepIDP在底层集成了小模型推理引擎和大型模型推理引擎。该架构可以根据任务的复杂度和需求,自动调度最合适的模型进行处理,对外提供标准化的服务接口。

这种融合架构屏蔽了底层模型的差异,实现了“无感调用”,用户无需刻意区分某个识别能力是由大模型还是小模型提供,只需专注于自身业务需求即可。

在确保高性能和高效率的同时,简化了系统维护,为业务创新提供了更灵活的底层AI能力支持。